728x90

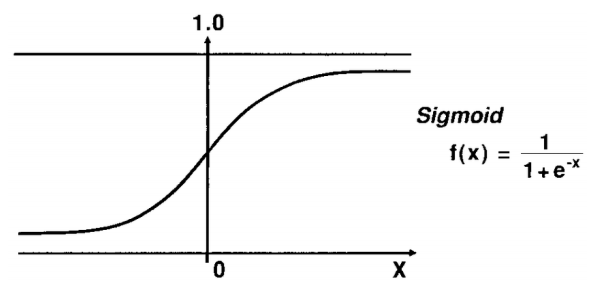

x(입력)가 음수 방향으로 갈 수록 y(출력)가 0에 가까워지고,

x(입력)가 양수 방향으로 갈 수록 y(출력)가 1에 가까워진다.

즉, 시그모이드 함수를 통과하면 0 에서 1 사이 값이 나온다

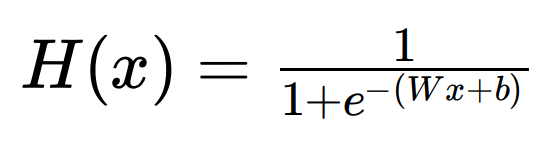

선형 회귀에서

가설은 H(x) = Wx + b

논리 회귀에서는

시그모이드 함수에 선형회귀 식을 넣는다.

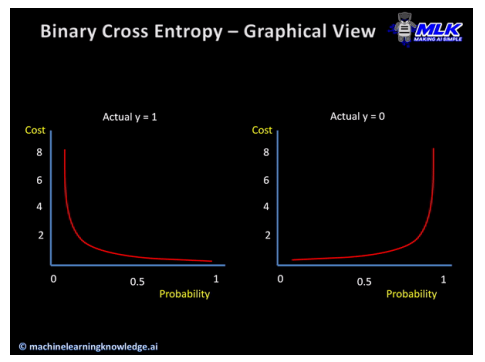

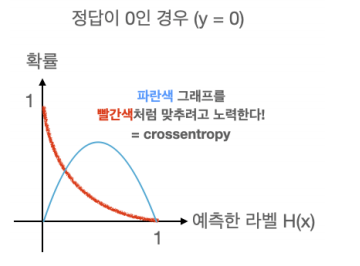

확률 분포 그래프 (X:라벨(클래스) | Y:세로축 확률 )

Crossentropy (확률 분포 그래프의 차 이를 비교)

임의의 입력값에 대해

원하는 확률 분포 그래프를

만들도록 학습시키는 손실 함수

Keras에서 이진 논리 회귀의 경우 binary_crossentropy 손실 함수를 사용

728x90

'AI(Artificial Intelligence)' 카테고리의 다른 글

| ReLU 함수 (Rectifical Linear Unit) (0) | 2024.06.24 |

|---|---|

| 다항 논리 회귀 (Multinomial logistic regression) (0) | 2021.09.01 |

| 논리 회귀 (Logistic regression) (0) | 2021.07.27 |

| 데이터셋 분할 (학습/검증/테스트) (0) | 2021.07.26 |

| 경사 하강법 (Gradient descent method) (0) | 2021.07.26 |